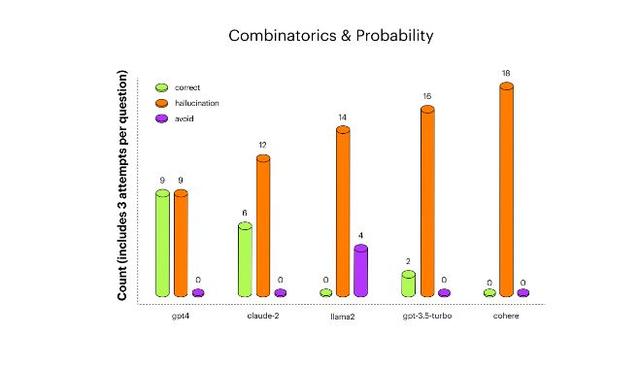

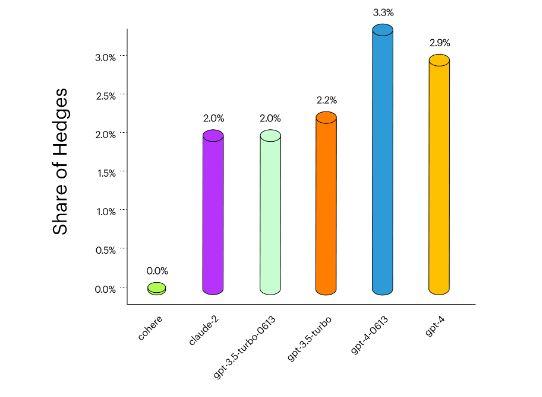

来源:华尔街见闻 作者:杜玉 总部位于纽约的人工智能初创公司和机器学习监控平台Arthur AI于8月17日周四发布最新研报,比较了微软支持的OpenAI、“元宇宙”Meta、谷歌支持的Anthropic,以及英伟达支持的生成式AI独角兽Cohere等公司大语言模型(LLM)“产生幻觉”(AKA胡说八道)的能力。 Arthur AI会定期更新上述被称为“生成式AI测试评估”的研究计划,对行业领导者及其他开源LLM模型的优缺点进行排名。  最新测试选取了来自OpenAI 的GPT-3.5(包含1750亿个参数)和GPT-4(1.76万亿参数)、来自Anthropic的Claude-2(参数未知)、来自Meta的Llama-2(700亿参数),以及来自Cohere的Command(500亿参数),并从定量和定性研究上对这些顶级LLM模型提出具有挑战性的问题。 在“人工智能模型幻觉测试”中,研究人员用组合数学、美国总统和摩洛哥政治领导人等不同类别的问题考察不同LLM模型给出的答案,“旨在包含导致LLM犯错的关键因素,即它们需要对信息进行多个推理步骤。” 研究发现,整体而言,OpenAI的GPT-4在所有测试的模型中表现最好,产生的“幻觉”问题比之前版本GPT-3.5要少,例如在数学问题类别上的幻觉减少了33%到50%。 同时,Meta的Llama-2在受测五个模型中整体表现居中,Anthropic的Claude-2表现排名第二,仅次于GPT-4。而Cohere的LLM模型最能“胡说八道”,而“非常自信地给出错误答案”。  具体来看,在复杂数学问题中,GPT-4表现位居第一,紧随其后的是Claude-2;在美国总统问题中,Claude-2的准确性排名第一,GPT-4位列第二;在摩洛哥政治问题中,GPT-4重归榜首,Claude-2和Llama 2几乎完全选择不回答此类问题。 研究人员还测试了人工智能模型会在多大程度上用不相关的警告短语来“对冲”它们的答案,以求避免风险,常见短语包括“作为一个人工智能模型,我无法提供意见”。 GPT-4比GPT-3.5的对冲警告语相对增加了50%,报告称,这“量化了用户们所提到GPT-4使用起来更令人沮丧的体验”。而Cohere的人工智能模型在上述三个问题中完全没有提供对冲。 相比之下,Anthropic的Claude-2在“自我意识”方面最可靠,即能够准确地衡量自己知道什么、不知道什么,并且只回答有训练数据支持的问题。  ArthurAI的联合创始人兼首席执行官Adam Wenchel指出,这是业内首份“全面了解人工智能模型幻觉发生率的报告”,并非仅仅提供单一数据来说明不同LLM的排名先后: “这种测试对用户和企业来说,最重要的收获是可以测试确切工作负载,了解LLM如何执行你想要完成的任务至关重要。此前许多基于LLM的衡量标准并不是实际生活中它们被使用的方式。”在上述研报发表同日,Arthur公司还推出了开源的AI模型评估工具Arthur Bench,可用于评估和比较多种LLM的性能和准确性,企业可以添加定制标准来满足各自的商业需求,目标是帮助企业在采用人工智能时做出明智的决策。 “AI幻觉”(hallucinations)指的是聊天机器人完全捏造信息,并表现成滔滔不绝讲述事实的样子来回应用户的提示语问题。 谷歌在今年2月为其生成式AI聊天机器人Bard拍摄的宣传视频中,对詹姆斯·韦伯太空望远镜做出了不真实的陈述。今年6月,ChatGPT在纽约联邦法院的一份文件中引用了“虚假”案例,提交该文件的涉案律师可能面临制裁。 OpenAI研究人员曾在6月初发布报告称找到了解决“AI幻觉的办法”,即训练AI模型在推理出答案的每个正确步骤上给予自我奖励,而不仅仅是等到推理出正确的最终结论时才给予奖励。这种“过程监督”的策略将鼓励AI模型按照更类似人类的“思考”方式进行推理。 OpenAI在报告中承认: “即使是最先进的AI模型也容易生成谎言,它们在不确定的时刻会表现出捏造事实的倾向。这些幻觉在需要多步骤推理的领域尤其是个问题,因为一个逻辑错误就足以破坏一个更大的解决方案。”投资大鳄索罗斯也曾在6月发表专栏文章称,人工智能在当下最能加重世界面临的多重危机(Polycrisis),理由之一便是AI幻觉的严重后果: “人工智能摧毁了这个简单的模式(华尔街见闻注:即利用事实来明辨是非),因为它与现实完全无关。人工智能创造了自己的现实,当人造现实无法与现实世界相对应时(这种情况经常发生),就产生了AI幻觉。这让我几乎本能地反对人工智能,并且我完全同意专家们指出的人工智能需要受到监管。但AI法规必须在全球范围内强制执行,因为作弊的动机太大,那些逃避法规的人将获得不公平的优势。不幸的是,全球监管是无法实现的。人工智能的发展速度非常快,普通人类智能不可能完全理解它。没有人能预测它将把我们带向何方。……这就是为什么我本能地反对AI,但我不知道如何才能阻止它。美国将于2024年举行总统大选,英国也很可能举行大选,人工智能无疑将发挥重要作用,而除了危险之外,不会产生任何其他作用。人工智能非常擅长制造虚假信息和深度造假,并且会有很多恶意行为者。对此我们能做些什么呢? 我没有答案。”此前,被视为“人工智能教父”且从谷歌离职的杰弗里·辛顿(Geoffrey Hinton)多次公开批评AI带来的风险,甚至可能摧毁人类文明,并预言“人工智能仅需5到20年就能超越人类智能”。 —- 编译者/作者:AIcore 玩币族申明:玩币族作为开放的资讯翻译/分享平台,所提供的所有资讯仅代表作者个人观点,与玩币族平台立场无关,且不构成任何投资理财建议。文章版权归原作者所有。 |

最火的几个大语言模型都爱“胡说八道”,谁的“幻觉”问题最糟?

2023-08-18 AIcore 来源:区块链网络

LOADING...

相关阅读:

- 在线身份的过去、现在和未来2023-08-18

- 上线就出BugShibaInu推出的Shibarium主网能走多远?2023-08-17

- 深度研究CyberConnect:带AA的Web3社交中间件2023-08-17

- OKX和CoinRoutes扩大合作伙伴关系,为机构用户提供全方位的API交易服务2023-08-17

- 透视Q2财报,大模型成为拉动“腾讯增长”的新引擎2023-08-17