观点 | “用户使用场景”才是AI平台发展的关键

时间:2023-09-05 来源:区块链网络 作者:AIGC

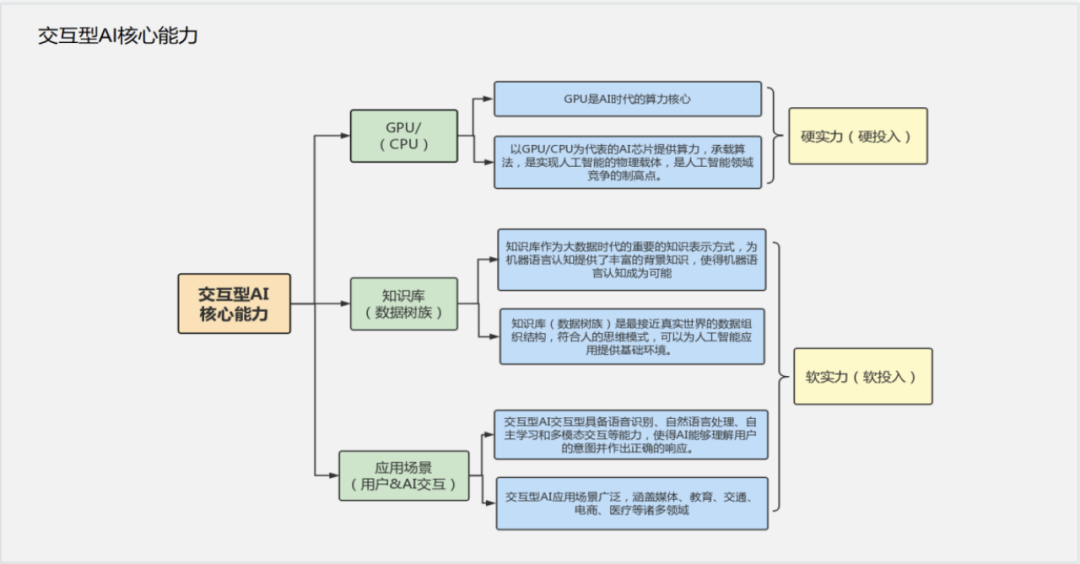

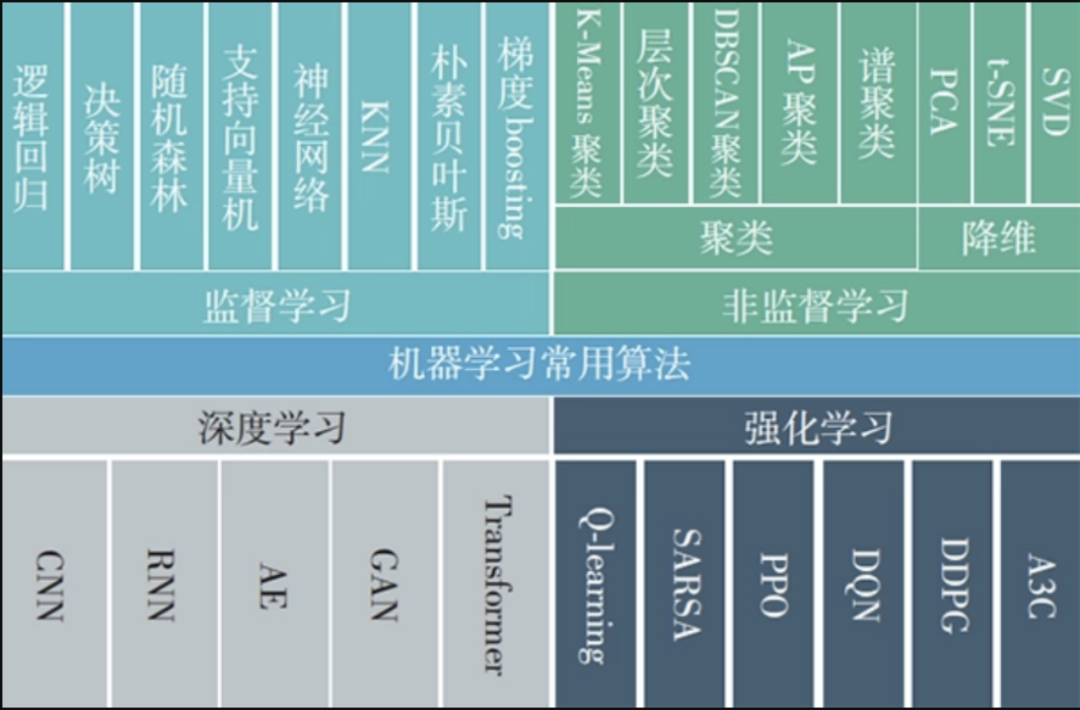

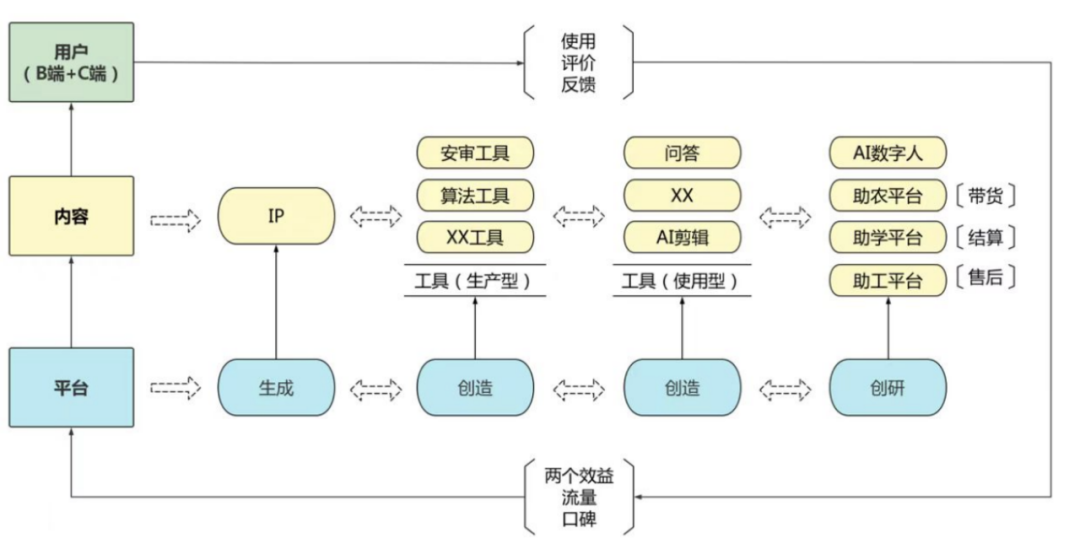

原创:杨继红 来源:AI黑马  图片来源:由无界 AI生成 AI黑马 导读 ???? “AI就是新石器时代的弓箭。”AI形成的学习能力取决于参数的规模。GPT-2大约有15亿个参数,而GPT-3最大的模型有1 750亿个参数,上升了两个数量级。根据媒体猜测但还未被证实的消息,GPT-4的参数可能达到100万亿规模。 本文主要探讨:新时代交互型AI平台的能力与建设、机遇与挑战。有别于一些传统观点认为人工智能建设主要就是硬件建设,中央广播电视总台视听新媒体中心副主任杨继红从“人”的角度出发,强调“人”也就是用户,才是决战人工智能这场战役中的战略性资源。她认为,“软技术”才是科技创新的弯道超车、换道超车的 “黄金赛道”。牢牢把握“用户使用场景”这一破局“胜负手”。 浅谈交互型AI平台的硬实力与软实力 01前言 唯一不变的是变化创新永远不停歇,新技术不断涌现,AI驱动下的技术创新正在深刻地改变着我们的生活和工作方式。 如果说电脑、网络、互联网的普及,是计算机带来的变革浪潮,那么AI的大兵压境则更加强大、更加全面。传统的行业和职业正在受到人工智能技术的冲击和颠覆,许多传统岗位正在被取代,需要不断学习和适应新技术和新模式。 当AI在本篇文章中,我尝试提出一个全新视角同大家一起审视新时代交互型AI平台的能力与建设、机遇与挑战。有别于一些传统观点认为人工智能建设主要就是硬件建设,我尝试站在更高的维度上用硬实力与软实力来解构日新月异的人工智能能力,从“人”的角度出发,强调“人”也就是用户,才是决战人工智能这场战役中的战略性资源。  02交互型AI平台的“硬实力”和“软实力” 02交互型AI平台的“硬实力”和“软实力” 1.交互性AI中的硬实力 1.1 以CPU/GPU为代表的计算机硬件 计算机硬件是AI的基础。首先,计算机硬件直接决定了AI处理复杂计算任务的能力。处理大量数据、进行深度学习算法的计算和训练等,需要拥有足够强大的计算能力,CPU/GPU的性能直接决定了AI的计算速度和效率。其次,CPU/GPU作为硬件设备需要支持AI软件运行环境。AI涉及到大量的数据处理和计算任务,需要特殊软件环境来支持运行。此外,计算机硬件还需要具备较高的可扩展性和可编程性。AI应用场景广泛,需要针对不同的场景和应用提供不同的AI解决方案。只有计算机硬件具备较高的可扩展性,才能快速实现资源的动态分配和扩容。最后,计算机硬件还需要具备可编程性,以便开发人员能够快速优化算法和解决方案。下图为AI系统平台基础硬件组成与功能:  2.“软实力”是交互型AI的压舱石 2.1 知识图谱塑造AI基本盘 AI的知识图谱是一个结构化的知识库,它包含了广泛的领域知识,用于支持人工智能系统的学习和推理。知识图谱由实体(如人物、地点、事件等)和它们之间的关系构成。它可以包括各种类型的知识,包括定义、属性、类别、关联等。  知识图谱的构建和使用是AI技术的重要组成部分。它可以帮助AI系统获取、组织和存储各种领域的知识和语义信息,提高AI系统的认知能力和智能化程度。知识图谱可以应用于自然语言处理、推荐系统、问答系统、信息检索等多个方面。 举一些大家熟悉的例子,谷歌知识图谱、百度百科、以及维基百科等都是知识图谱。 2.2 算法水平驱动能力升级 2.2.1 算法的重要性 算法是实现AI各项任务的重要手段。算法的设计和改进也是推动AI发展和进步的关键。算法的重要性体现在以下三个方面: ① 影响模型的准确性和效率:不同的算法会影响到模型的准确性和计算效率。选择合适的算法可以提高模型的准确性并减少运算时间。 ② 满足不同的需求和场景:不同的场景和应用有不同的需求,需要选择不同的算法来满足。 ③ 提供决策支持:根据不同的问题和数据,算法可以提供决策支持,并对数据进行有效的分析和预测。 2.2.2 常见算法 AI用到的算法有很多,以适配不同的应用场景和需求。常见的有机器学习算法、深度学习算法、自然语言处理算法、推荐算法等四大类。  ① 机器学习算法: (1)监督式学习算法:如线性回归、逻辑回归、支持向量机、决策树、随机森林等。 (2)非监督式学习算法:如K-Means聚类、层次聚类、Expectation–Maximization算法等。 ② 深度学习算法: (1)卷积神经网络(CNN):主要应用于图像处理和计算机视觉任务。 (2)循环神经网络(RNN):主要应用于自然语言处理和语音处理等序列化任务。 (3)生成对抗网络(GAN):主要应用于生成图像、文本等任务。 (4)变换器网络(Transformer):主要应用于机器翻译、文本摘要等任务。 ③ 自然语言处理算法: (1)关键词提取:如TF-IDF算法、TextRank算法等。 (2)命名实体识别:如条件随机场模型等。 (3)句法分析算法:如规则模型、转移模型等。 (4)情感分析算法:如词典模型、机器学习模型等。 ④ 推荐算法: (1)基于内容推荐:如TF-IDF算法、LDA算法等。 (2)基于协同过滤推荐:如UserCF、ItemCF、LFM算法等。 (3)深度学习推荐:如DeepFM、Wide&Deep、DIN、BERT4Rec等。 算法是人工智能实现各类任务的基石。随着技术的不断发展和创新,新的AI算法也在不断涌现。提升AI能力的关键,在于为合适的场景挑选匹配合适的算法。从这一点上讲,人工智能的关键仍然在人工设计。 2.3 训练场景影响进化速率 2.3.1 训练的重要性 训练是使AI模型学习并获取知识和技能的过程,因此对于人工智能至关重要。 ① 提高模型准确性:通过合理的数据集选择和足够的训练次数,AI模型可以逐步学习数据中的规律和特征,从而提高模型的准确性和精度。 ② 支持模型的泛化能力:训练使模型具有泛化能力,即能够处理在训练集以外的新数据样本,并在其它情况下发挥作用。 ③ 增进模型的鲁棒性:训练可以使AI模型对于一些噪声数据、伪造数据和干扰数据具有更好的处理能力和鲁棒性。 ④ 对AI模型进行更新和迭代:通过训练,AI模型可以不断更新和改进,以满足实际应用需求。 ⑤ 改善模型的可解释性:AI数据模型的可解释性在许多领域中非常重要。通过训练,可以提高模型的可解释性和透明度,使其更易于理解和使用。 2.3.2 训练场景影响进化速率 设定与选择训练场景对于AI模型的性能和表现至关重要,直接决定了模型的质量和可用性。需要在训练过程中对数据进行预处理、选择合适的算法、优化算法超参数、控制欠拟合和过拟合等进行优化,从而使得AI模型训练出来的结果更加精准和可靠。这些最重要的做都本质上依靠人工参与,也体现出“人”是最核心战略资源的地位。 ① 监督式学习场景:通过给模型提供 labeled 的数据集,指示该数据属于哪一类别或目标值等。 ② 非监督式学习场景:训练数据集没有特定的标签或目标值,模型需要根据数据集的统计特征,自行发现数据中的规律和特征,以此来对数据处理和分类。 ③ 半监督式学习场景:包含标记和未标记的数据,模型需要学会如何将这些未标记的数据分类。 ④ 强化学习场景:模型不断与环境交互,在每一个时刻对环境进行观察和交互,并基于该反馈信息调整模型的策略。 ⑤ 自然语言处理场景:训练数据集一般是大量的文本数据,模型需要学会如何理解文本数据以及文本之间的关系。 ⑥ 计算机视觉场景:训练数据集通常是图像或视频数据,模型需要学会如何理解和处理这些图像数据以实现目标检测、图像识别等任务。 03“用户使用场景”是总量稀缺的战略资源1.有限的用户,无限的数据 目前通过扩展计算机硬件和扩充数据库来提高人工智能产品的准确性和智能化水平有一定的限制和局限性。一方面,扩建计算机硬件和扩充数据库需要大量的人力、财力和时间等投入,且随着系统规模的不断扩大,对资源的需求会越来越大。另一方面,目前人工智能领域的技术发展还面临着许多不确定因素,如算法的有效性、自我学习的效果等。这些因素都会影响人工智能产品的发展空间。 相对于无限的数据,对于用户资源的争夺则是一场此消彼长的零和博弈。如果一款人工智能产品拥有大量用户和高频率使用,就可以通过对用户使用数据的监控和分析来实现人工智能产品的智能化升级,不断完善产品体系,增加使用价值。 更多的用户,缔造更先进的平台;更先进的平台,打造更优秀的体验;更优秀的体验,吸引更多的用户。  未来不同意识形态下AI平台的能力差异,根本上是由用户数量和使用频次的差异决定的。要获得更多用户和频繁的使用频次,就要在产品用户界面、功能、服务质量、市场推广等方面进行持续改进和优化,不断满足用户需求和提高用户体验,赢得用户的信任和忠诚度。 2.“马太效应”蚕食鲸吞 马太效应是指在一定条件下,对优秀的人才持续加以扶持,从而导致人才之间的差距越来越大的现象。 在人工智能发展的过程中,往往是先进技术或先进企业更容易获得首批用户和市场份额,从而会有更多的投资和更好的收益。这种现象会进一步加强行业的领先地位。 另一方面,AI技术的发展也需要大量的专业人才。领先企业和平台由资源可以持续投入更多资金和资源取得人才优势,从而让后发企业彻底失去追赶能力。 最重要的是,领先平台会提供更好的用户体验,目前AI to C市场马太效应已经凸显。从用户心理来看,习惯使用一种AI产品的用户在切换到别的同类型产品时需要重新学习和适应,需要消耗大量时间和精力。从数据规模来看,大量的用户数据的积累对产品的使用效果和分析意义重大,留存用户数据是建立这类产品的关键,新产品具有先天劣势。AI系统天生的“飞轮效应”,进一步放大了“马太效应”在用户体验上的呈现。 04结语一个有趣的说法:AI就是新石器时代的弓箭。 AI形成的学习能力取决于参数的规模。根据学界经验,深度神经网络的学习能力和模型的参数规模呈正相关,也就是模型参数越多学习能力越强。GPT-2大约有15亿个参数,而GPT-3最大的模型有1 750亿个参数,上升了两个数量级。根据媒体猜测但还未被证实的消息,GPT-4的参数可能达到100万亿规模。 业内有专家认为,硬科技都是为“软技术”发展提供关键零部件和硬件接口,围绕“软技术”供应链的需求进行创新。“软技术”才是科技创新的弯道超车、换道超车的 “黄金赛道”。 央视频已经摸索出了一套行之有效的组合拳:首先将用户需求提炼为助医、助农、助美、助学等一系列AI赋能方向,再通过模糊搜索语义匹配吊起总台海量媒资,构建各应用场景上的高频使用模型,形成知识库、算法等“软实力”的自组织自学习,倒逼GPU算力、CDN带宽等硬实力建设。牢牢把握“用户使用场景”这一破局“胜负手”。 令人振奋的是,目前来看GPT的技术方向已经明确,不存在难以逾越的技术障碍。我们拿出中国人最擅长的“长期主义”精神,可以把这只“新石器时代”的弓箭射得最准最远。 |

玩币族移动版

玩币族移动版