推理速度达英伟达 GPU 的 10 倍,刚获 6.4 亿美元融资的 Groq 是什么来头?

时间:2024-08-08 来源:区块链网络 作者:techflow深潮

以快著称的 AI 芯片独角兽 Groq,官宣融资 6.4 亿美元,最新估值也暴涨到 28 亿美元。 撰文:元宇宙之心 8 月 5 日,美国人工智能芯片初创公司 Groq 官宣获得 6.4 亿美元最新融资,公司估值也来到了 28 亿美元。 此轮融资由华尔街资管巨头贝莱德的 BlackRock Private Equity Partners 领投,思科的 Cisco Investments 和三星电子的 Samsung Catalyst Fund 也参与其中。Groq 背后的技术创新实力和财力支持可见一斑。 01.1 分钟项目速览 1.项目名称:Groq 2.成立时间:2016 年 3.产品简介: Groq 推出的新型 AI 加速芯片 LPU,专为大语言模型量身定制,具有高速推理性能。其芯片性能表现比常规的 GPU 和 TPU 提升 10 到 100 倍,推理速度达到了 NVIDIA GPU 的 10 倍。 4.创始人团队: Jonathan Ross:创始人兼 CEO,谷歌 TPU 项目核心研发人员 Yann LeCun:图灵奖得主、深度学习三巨头之一,担任技术顾问 5.融资情况: 2017 年,Groq 在成立初期获得了种子轮融资 1030 万美元; 2018 年,Groq 在 A 轮融资中筹集了 5230 万美元,由 Social Capital 领投; 2020 年,Groq 在 B 轮融资中筹集了 1.5 亿美元,由 Tiger Global Management 领投,参与者还包括 D1 Capital Partners 和 The Spruce House Partnership; 2021 年,Groq 在 C 轮融资中筹集了 3 亿美元,由 Tiger Global Management 和 D1 Capital Partners 继续支持; Groq 在最新一轮融资中筹集了 6.4 亿美元,由 BlackRock Inc.基金领投,思科、三星跟投。 02.创新驱动的 AI 处理器先锋 Groq 的创立过程可以被视为创新和技术突破的一个典范。 Ross 在创办 Groq 之前,曾在谷歌担任工程师,负责推动深度学习和计算架构方面的研究。在谷歌工作期间,Ross 发现传统计算架构在处理现代 AI 任务时存在显著的性能瓶颈,特别是在深度学习和大规模数据分析方面。

传统的 CPU 和 GPU 无法满足这些任务对并行计算和低延迟的高要求。这种认知促使 Ross 离开谷歌,创办一家专注于突破传统计算限制的公司——Groq。 Groq 的创始团队在公司创立初期集中精力于硬件设计和技术研发。团队成员来自于高性能计算和半导体领域的顶尖人才,具备丰富的经验和技术背景。早期的工作包括处理器架构的设计、原型的开发以及性能测试。 Groq 的技术理念围绕着一种创新的处理器架构展开,旨在提供比现有处理器更高的计算性能和效率。公司的目标是设计一种能够突破 CPU 和 GPU 限制的硬件平台,以满足 AI 和 HPC 领域对计算能力的不断增长的需求。

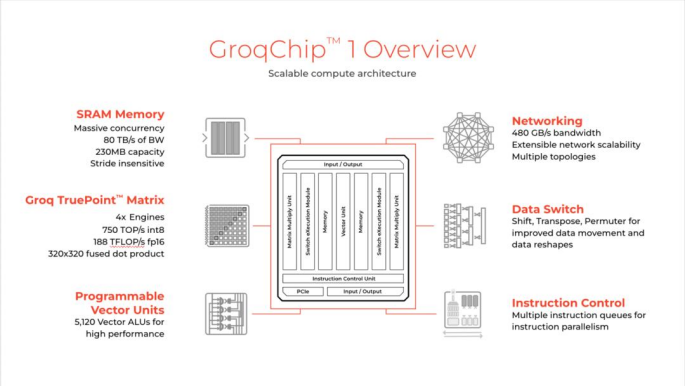

随着技术的成熟和市场需求的增加,Groq 开始扩展其业务范围,进入了数据中心、云计算和边缘计算等领域。目前,该公司已与多个行业领先的技术合作伙伴建立了战略合作关系,推动其产品在全球范围内的应用。 03.重塑高性能计算 自创立以来,Groq 凭借其突破性的技术和卓越的产品,迅速成为人工智能(AI)和高性能计算(HPC)领域的先锋。 Groq 的技术核心在于其创新的处理器架构。与传统的 CPU 和 GPU 处理器不同,Groq 的设计理念着眼于提升计算能力和效率,特别是针对现代 AI 和数据密集型应用的需求。 高度并行化设计:Groq 的处理器架构采用了极高的并行化设计,集成了大量计算单元,能够同时处理大量的数据。这种设计不仅提升了计算能力,还降低了数据处理的延迟。 简化数据路径:传统处理器常常面临数据传输瓶颈,Groq 的架构通过优化数据路径和高速缓存设计,显著减少了数据传输延迟。这样一来,处理器能够以更高的效率处理大规模数据集,满足 AI 训练和推理过程中的高性能要求。 灵活的配置选项:Groq 提供了多种配置选项,允许用户根据具体应用需求调整计算资源。这种灵活性使得其处理器可以广泛应用于不同的计算场景,从数据中心到边缘计算环境。

Groq 的 AI 加速器是其产品阵容中的核心组成部分,专为加速深度学习模型的训练和推理而设计。其优势主要体现在以下三个方面: 高吞吐量和低延迟:AI 加速器通过提高处理能力和降低延迟,显著加快了机器学习模型的训练速度。这对于需要处理海量数据的应用,如图像识别和自然语言处理,尤其重要。 优化算法支持:Groq 的加速器优化了各种机器学习算法,包括卷积神经网络(CNN)、循环神经网络(RNN)等。通过硬件层面的优化,加速器能够高效执行这些复杂的计算任务,提高模型的训练效率和推理性能。 扩展性和可配置性:加速器设计支持高扩展性,能够应对不同规模的数据处理任务。用户可以根据需要配置多个加速器,构建高性能计算集群,以满足大规模 AI 应用的需求。 凭借高度并行化的设计、优化的数据路径、以及强大的 AI 加速能力,Groq 为数据中心、云计算和边缘计算等多个领域提供了卓越的技术支持。 随着技术的不断发展和产品的持续优化,Groq 正在为现代计算需求提供前所未有的解决方案,推动计算科技向更高水平迈进。 作为 AI 芯片领域黑马的 Groq,其 LPU 芯片的高速推理能力毋庸置疑。但随着公司估值的暴涨和市场的期待,Groq 也在面临着一系列的挑战与问题。 04.挑战与机遇并存 首先便是 LPU 的容量问题,虽然在处理大语言模型时展现出了卓越的性能,但内存较小导致在实际部署时可能需要大量的硬件资源。 据分析,LPU 在运行 LLaMA 70B 等大模型时,Groq 的硬件需求和成本可能远高于预期,这无疑增加了公司在大规模部署时的经济压力。 其次,LPU 的专用性虽然在特定任务上提供了优势,但也限制了其在更广泛 AI 任务中的应用。与 GPU 相比,LPU 的通用性不足可能影响其在多样化 AI 场景中的竞争力。

作为初生产品与初创公司,Groq 在技术成熟度、市场认可度以及生态系统建设方面还有很长的路要走。它需要不断优化产品,扩大研发团队,并与行业伙伴建立合作关系,以加速技术的商业化进程。 展望未来,Groq 的发展机遇同样巨大。随着 AI 技术的不断进步和应用场景的拓展,相关企业对高效能 AI 芯片的需求日益增长。Groq 若能有效解决成本和通用性问题,其 LPU 芯片有望在 AI 推理市场占据重要地位。 Groq 公司计划到 2025 年 3 月底前推出 10.8 万个 LPU,这一宏伟目标若能实现,将进一步巩固其在行业中的领导地位。Groq 如何在激烈的市场竞争中不断突破自我,实现技术创新与商业成功的双重飞跃,值得我们持续关注。 |

玩币族移动版

玩币族移动版