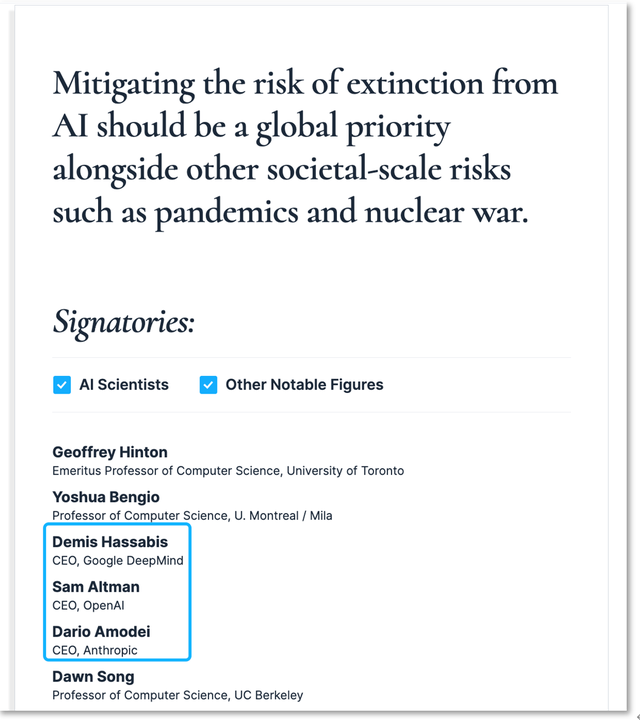

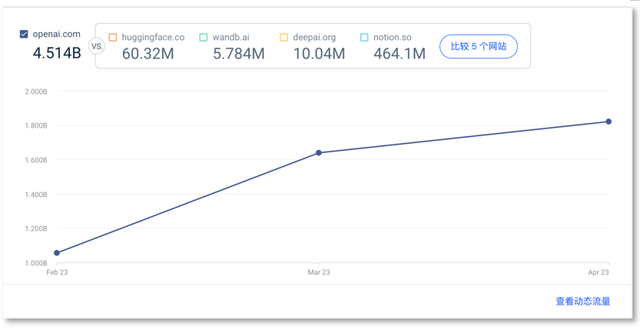

又一封“群星云集”警示AI风险的公开信来了,这封信的内容简短但措辞炸裂:减轻 AI 带来的灭绝风险,应该与管控流行病和核战争等其他社会级规模的风险一样,成为一项全球优先事项。 5月30日,这纸原文只有22个单词的声明,出现在美国非营利组织“人工智能安全中心(Center for AI Safety)”的官网上,超过350名AI领域的企业界和学界名流为之签名。 与2个半月前“生命未来研究所”发出的、上千名人签名呼吁“暂停训练大模型6个月”的那封公开信相比,最令人瞩目的是,这次,OpenAI、谷歌DeepMind 和 Anthropic的CEO都签了名。 值得注意的是,在签署“22字声明”前,OpenAI、谷歌、Anthropic三家公司的负责人都出席了5月4日白宫发起的AI风险治理会议。面对风险管理,AI三巨头近段时间显得比政府还着急。 最近,这三家公司CEO频繁地与欧洲多国首脑会晤,试图影响正在推进中的欧盟《人工智能法案》,这项法案很可能影响OpenAI等公司的生成式大模型进入欧洲市场,而那里是流量新神话缔造者OpenAI都暂未拿下的“处女地”。 求管控AI风险的背后,是AI公司们满满的市场“求生欲”。 三巨头留名最新AI风险声明“Mitigating the risk of extinction from AI should be a global priority alongside other societal-scale risks such as pandemics and nuclear war.” 22个单词组成了一纸《人工智能风险声明》,将AI带来的风险直接以“灭绝(extinction)”措辞,严重程度堪比“流行病(pandemics)”和“核战争(nuclear war)”,管控紧迫度被表述为“应该成为全球优先事项”。 5月30日,在非营利组织“人工智能安全中心(Center for AI Safety)”官网晒出的这纸声明下,有包括科学家、企业领导人在内的350多人签了自己的名字。  AI三巨头的CEO的名字出现在名单中 “我们必须让这个问题上公开化,因为许多人只在彼此之间默默地交谈。”人工智能安全中心的执行主任丹·亨德里克斯(Dan Hendrycks)在谈到声明的目的时表示,一句话声明的简明扼要是特意为之,目的是让更多的科学家建立“广泛联盟”,因为一些科学家可能还没有就AI有哪些风险以及预防风险的最佳解决方案达成一致。 350个签名中,打头的两位是图灵奖得主杰弗里·辛顿 (Geoffrey Hinton)和约书亚·本希奥(Youshua Bengio),紧跟着出现了戴米斯·哈萨比斯(Demis Hassabis)、山姆·奥特曼(Sam Altman)和达里奥·阿莫迪(Dario Amodei)三位,他们分别为谷歌DeepMind、OpenAI和Anthropic三家全球知名人工智能开发公司的CEO。 一些中国知名学者也签了名,如清华大学智能产业研究院院长张亚勤、中科院自动化研究所的曾毅教授、清华智能产业研究院的副教授詹仙园。 如果把“用知识服务人类”视作知识分子的社会责任,专家、学者的签名很好理解,被誉为“AI教父”的辛顿今年4月从谷歌辞职,此后一直在公开场域表达对人工智能失控的担忧;本希奥曾在今年3月非营利组织“未来生命研究所(Future of Life Institute)”发表的那一封“暂停巨型AI实验”公开信上签过字。 但在2个月前的那封信上,谷歌DeepMind、OpenAI和Anthropic这三家公司的负责人并没有签名,相比这次的“22字声明”,那封信还详细阐述了AI可能带来的各种具体风险,甚至给出了明确的风险管理原则,至今已积累收集到31810个签名。 上次那封信引发的AI圈内的明显分歧是:到底应不应该为了风险而暂停AI实验。 当时,人工智能领域的学者吴恩达当时在LinkedIn上表示,全面暂停AI训练6个月的想法是一个糟糕、不切实际的想法。后来,OpenAI CEO山姆·奥特曼Sam Altman更直观地表达了暂停的无意义,“我们暂停6个月,然后呢?我们再暂停6个月?” 但这次,AI企业三巨头领导者带头签了这个风险阐述模糊但措辞严峻的“22字声明”从他们表态对声明的认同中,透露出管控AI风险的紧迫性。 短短的两个月半内,是什么致使AI公司们都转变了态度? OpenAI访问量增速放缓现在,人类即便没有被AI灭绝,但生成式AI在作恶者的驱使下露出了“黑暗面”。 比如,AI的仿声仿貌功能正在被用作诈骗工具,AI生成图片、文字的能力不仅被用来造假新闻,造出的“黄谣”直接伤害到普通个体的声誉。 相比生成式AI对常识“胡说八道”、会陷入逻辑陷阱、解数学题不太行、数据隐私安全等缺陷,受害案例显示出的AI破坏力更具体、更直观地呈现在公众眼前。对AI开发公司来说,最直接的影响是那些刚刚开放AI应用给公众的开发公司,还能在负面舆论中的获得多少增量市场? 以访问量规模增长最快的、提供文本生成应用ChatGPT的OpenAI为例,其网页访问量从去年秋季的每月约2000万次增长到2023年4月的18亿次,刷新了互联网流量增长神话。但从网络分析公司SimilarWeb收集的数据看,OpenAI的网页访问量增速在放缓。  OpenAI的网页访问量增速放缓 OpenAI网页的流量贡献主要来自于美国本土,份额能占到10.25%,其次是印度(8.82%)、日本(7.48%)、印尼(3.84%)、加拿大(3.06%),每月的增量也来自这些国家,其中从日本获得访问增量最多,打到28.86%。而俄罗斯、中国及欧洲各国基本没有为之贡献明面的流量,这些国家和地区的网民访问OpenAI是受限的。 OpenAI自己切断了这些市场,最大的原因是各国对互联网的管理政策不一。相比俄罗斯和中国,欧洲似乎是更令人工智能公司们渴望的市场,然而,欧盟已经明确了针对人工智能立法。 此后,OpenAI、DeepMind、Anthropic三家公司的CEO都出现在欧洲。 三位CEO在欧盟立法前齐现欧洲4月27日,欧洲议会成员已经就《人工智能法案(Artificial Intelligence Act)》提案达成临时政治协议。5月11日,欧洲议会两个委员会通过了对《人工智能法案》(以下简称《法案》)提案的谈判授权草案。这一草案将于6月12日到15日提交欧洲议会全会表决,之后欧洲议会将与欧盟理事会就法律的最终形式进行谈判。 《法案》的立法者根据风险级别对不同的人工智能工具进行分类,从最低到有限、高和不可接受。使用这些工具的政府机构和企业将根据风险级别承担不同的义务。《法案》还将严格禁止“对人类安全造成不可接受风险的人工智能系统”,包括有目的地操纵技术、利用人性弱点或根据行为、社会地位和个人特征等进行评价的系统等。 如果《法案》顺利颁布,这将是人类历史上首部针对人工智能的法律。由于《法案》适用于在欧盟区内运行的所有人工智能系统,领导AI技术的美国企业如若想到打入欧洲市场,显然将会受到制约。 比如,《法案》要求,开发生成式AI工具的公司必须披露他们是否在系统中使用了受版权保护的材料。对于用各种来源的海量数据训练大模型的AI公司而言,这个要求将直接把他们拦在欧洲之外。 OpenAI、DeepMind、Anthropic都开始关注欧洲动向。 5月下旬,OpenAI CEO山姆·奥特曼多次前往欧洲,分别与西班牙、波兰、法国和英国的政府首脑进行了会谈,讨论人工智能的发展潜力、威胁以及监管等问题。DeepMind 的CEO德米斯·哈萨比斯、Anthropic的 CEO达里奥·阿莫迪也与英国首相苏纳克会过面。  英国首相苏纳克会见AI三巨头的CEO 与欧洲各国首脑交流,AI科技公司们试图以此影响《法案》进程。不止如此,山姆·奥特曼还用演讲、采访等各种方式面向欧洲大众发声,希望“民意”与他们站在一起。 在伦敦大学学院的演讲中,奥特曼坚持着他的观点:人们对AI的种种担心有道理,但AI的潜在好处要大得多。谈到AI监管,奥特曼表示OpenAI欢迎监管,但需要“正确的监管方式”,因为“过度监管可能会损害小公司和开源运动”。 5月25日,奥特曼对英国媒体表达他对《法案》的看法,“很多措辞是不恰当的,”他认为,目前的欧盟 AI 法案草案将会造成过度监管的情况,“但我们听说它将调整,他们还在谈论这件事。” 距离《法案》的最终表决还有不到半个月时间,奥特曼的“游说之旅”还在继续。公开消息显示,奥特曼接下来会与欧盟产业主管埃里·布雷顿(Thierry Breton)会面,讨论欧盟应如何实施在人工智能方面全球领先的规则。 一系列的欧洲行之后,AI三巨头的三位CEO在“22字声明”下签字,认同声明中所述的全球优先管控AI风险之论。姿态背后是AI公司们试图在管控下扩大市场的“求生欲”。 —- 编译者/作者:元宇宙日爆 玩币族申明:玩币族作为开放的资讯翻译/分享平台,所提供的所有资讯仅代表作者个人观点,与玩币族平台立场无关,且不构成任何投资理财建议。文章版权归原作者所有。 |

签名支持全球管控AI,三巨头侧漏“求生欲”

2023-06-01 元宇宙日爆 来源:区块链网络

相关阅读:

- 小冰首批 GPT 网红明星 AI 克隆人提前上线,包括“半藏森林”等2023-06-01

- 阿里云智能发布音视频 AI 通义听悟,6 月 1 日正式公测2023-06-01

- 清智人工智能孵化器在清华科技园正式成立2023-06-01

- 瑞信:微软仍为首选 AI 股,上调目标价至 420 美元2023-05-31

- STEPN开发商FSL发布GNT V3,可基于用户自拍创作AIGC NFT2023-05-31